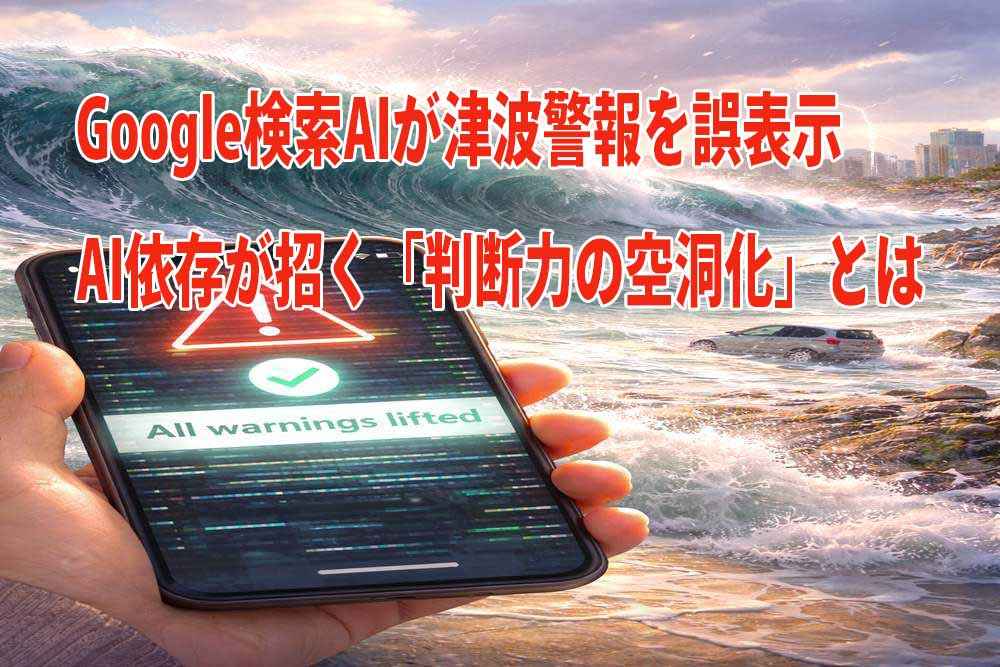

災害時に人々の行動を左右する情報が、誤って伝えられたとしたら何が起きるのか。青森県東方沖地震をめぐり、津波警報が継続していた時間帯にGoogle検索のAI概要が「すべて解除」と誤表示していた事例は、生成AIの技術的課題にとどまらず、人間側の判断力が静かに弱まっている現実を浮かび上がらせた。効率性と引き換えに失われつつある「考える工程」。本稿では、AI依存がもたらす構造的リスクと、誤情報に振り回されないための視点を検証する。

災害情報で起きたAIの誤表示

2025年12月8日深夜、青森県東方沖を震源とする地震をめぐり、津波警報・注意報が続いていた時間帯に、Google検索の「AIによる概要(AI Overview)」が誤って「すべて解除」と表示していたことが指摘された。災害情報という命に関わる分野において、AIの誤回答が利用者の判断を誤らせる危険性を示した格好だ。

時系列で見た警報と誤情報の食い違い

地震は12月8日23時15分ごろに発生し、気象庁は北海道・青森県・岩手県に津波警報、宮城県・福島県などに津波注意報を発表した。その後、12月9日2時45分ごろに津波警報は解除され、対象地域は津波注意報に切り替えられた。さらに9日6時20分ごろ、津波注意報もすべて解除された。

しかし、警報・注意報が継続していた12月9日2時10分ごろ、Google検索で「最新の津波情報について教えて」と入力すると、「AIによる概要」が「大津波警報・津波警報・津波注意報はすべて解除されている」などと誤って表示されたという。その後の検索でも、同様の誤表示が続いていたことが報じられている。

生成AIが抱える構造的リスク──ハルシネーション

検索エンジンの仕組みに詳しい専門家は、命に関わる分野でAI検索に依存する危険性を指摘する。生成AIは、文章として自然で整合的に見える一方、事実と異なる内容を含めてしまう「ハルシネーション」を起こしうる。見た目の説得力が高いため、利用者が誤りに気づきにくい点が特徴だ。

AI依存が引き起こす「判断の空洞化」

問題は誤表示そのものにとどまらない。AIが即座に答えを提示する環境に慣れるほど、人間側は検証や比較といった工程を省きやすくなる。その結果、個人や組織の中で「考える過程」が徐々に省略され、意思決定の質が低下していく。これが本稿で言う「判断力の空洞化」である。

研究が示唆する“考える工程”の弱体化

AI利用と認知活動の関係をめぐっては、MITで行われた予備的な実験として、ChatGPTを併用したグループで脳活動の指標が低下し、課題後の記憶保持や理解度が弱まったとする報告がある。研究規模は限定的で、結果の一般化には慎重さが必要だが、AIが思考の「近道」になる一方で、熟考の工程を削ぎやすい可能性を示唆している。

企業の意思決定で危うい領域

とりわけ、採用や人事評価、投資判断、リスク管理、戦略転換といった領域で、AIが提示した結論をそのまま採用する姿勢は危うい。前提条件やデータのわずかな違いで結論は容易に変わるにもかかわらず、AIの出力は文章が整っているため、会議や組織内で反論しづらい空気を生みやすい。

誤情報に絡め取られないための見分け方と対策

では、生成AIのハルシネーションに利用者はどう向き合えばよいのか。重要なのは、AIの回答を「最終結論」ではなく「仮説」や「論点整理」として扱い、必ず裏取りの工程を残すことだ。見分けるポイントと実践的な対策を以下に整理する。

| 観点 | 見分けるポイント | 具体的な兆候 | 対策の方向性 |

|---|---|---|---|

| 根拠 | 出典が見えない | 主語不明の断定が続く | 公式発表・一次資料で確認する |

| 精度 | 数字・時系列が整いすぎ | 例外や但し書きがない | 複数の信頼情報で照合する |

| 再現性 | 裏取りできない | 同内容が公的資料や大手報道に見当たらない | 一次情報に当たる |

| 表現 | 全称表現が多い | 「すべて」「必ず」など | 条件・例外の有無を確認する |

| 用途 | 判断をAI任せ | 結論をそのまま流用 | AIは下調べに限定する |

| 検証 | 反証が欠落 | リスク視点が抜ける | 誤りの可能性を問い直す |

| 緊急性 | 速報分野で依存 | 災害・医療情報をAIのみ参照 | 公的機関情報を最優先 |

| 組織 | ルール不在 | 責任が曖昧 | 使用範囲を明文化する |

求められるのは「禁止」ではなくガードレール

専門家が推奨するのは、AI利用の一律禁止ではない。「AIが支援すべき領域」と「人間の熟慮が必要な領域」を現場で共有し、言語化することだ。これは利便性を損なう話ではなく、判断の質を守るための設計にほかならない。

誤表示が突きつけた問い──思考の主導権は誰が握るのか

今回の誤表示は、技術の未熟さを超え、AI依存がもたらす構造的リスクを浮き彫りにした。効率化が進む時代だからこそ、人間が検証と熟慮の工程を手放さず、AIと健全な距離を保てるかが問われている。